2017.11.09 THU 機械が人を優しく支援する、リアルハプティクス技術 ― モーションリブ株式会社 溝口貴弘

| text by : | 編集部 |

|---|---|

| photo : | 編集部,モーションリブ株式会社,大塚実(動画提供) |

わたしたちはものに触れ、握るとき、持ち上げるとき、無意識のうちに「力加減」をしています。

しかしロボットはこの「力触覚」という生物の根源的な感覚を備えていません。

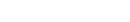

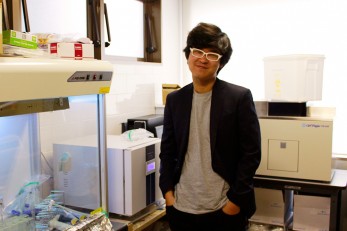

慶応大学の研究成果から生まれたモーションリブ株式会社はリアルハプティクス技術でこの力触覚をロボットに与え、ときに力強くときには優しく人間のように振る舞う社会を目指しています。機械やロボットが人と共生する未来について代表の溝口さんにお伺いしました。

■人間が原始的に持つ「触った時の力加減」をロボットに搭載する

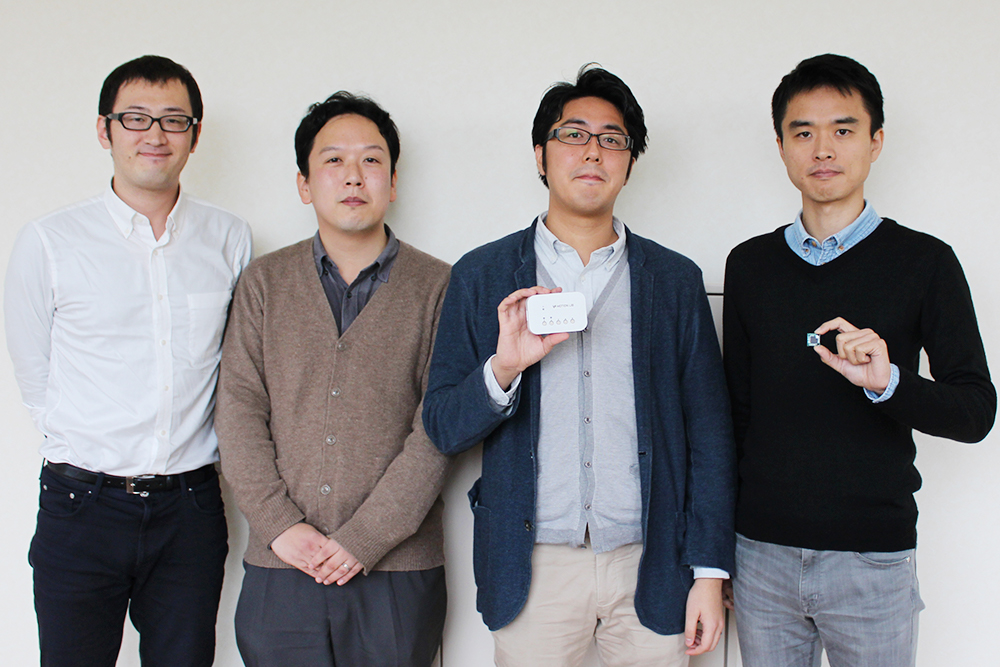

溝口:実際に体験してもらいながら説明しますね。

この装置を使うと、指で離れた場所にあるポテトチップを掴むことができます。

これだけでは単なる遠隔操作ですが、実際につまむとき指に「ポテトチップに触れた感覚」が伝わっていると思います。

単に「やさしく触れている」だけでなく、物体の固さや形状がデータとして伝わり「割らないようにする」動きを再現している

下に落ちているのは最初に掴んだとき力を入れ過ぎて割ってしまったポテトチップ。

つかんだときの感覚と、そのまま力を入れ過ぎて割ってしまった時のすっと力が抜けた感触も伝わります。一連の動きはその場でデータ化されますので、この「ポテトチップスが割れないように力加減ししていた動き」のデータを呼び出すことで次からはこのロボット単体で出来るようになります。

―僕がいまポテトチップを割らないようにつまんだ感覚・力加減をロボットに持たせている。

溝口:はい、この力触覚と呼ばれる感覚は、実は人類進化の過程で最初に出来た感覚と言われていて視覚や聴覚よりも10倍速く伝達される、とても原始的な人間の機能です。

最終的にはロボットが人間と同じ「触った感触」を持ち、あらゆる仕事が出来るようになる。

いまポテトチップを割ってしまったので、普通の人なら次は自然と力加減して割らないようにしますよね。実はこの「失敗しないように同じ作業をする」「力加減のデータを取得する」という仕組みがこれまで無かったのです。

実用化が進む手術用ロボットの世界でも、この「触った感覚で力加減する」の機能を持つものはほとんど無く、現状は3Dカメラなど補助的情報で補い「なるべく優しく臓器に触る」ということをしています。

しかしそこには「臓器を大切に扱おう」という力加減は存在していない。

リアルハプティクス技術であればロボットが臓器に触る時にそれが実現できます。元々この研究自体も慶応の医学部から相談されたことがきっかけで、現在CTOを務める飯田が2002年に世界で初めて成功しました。

■触った感覚がわからないほど小さく薄いなら「増幅」させればいい

―元々は医療における課題からスタートした。

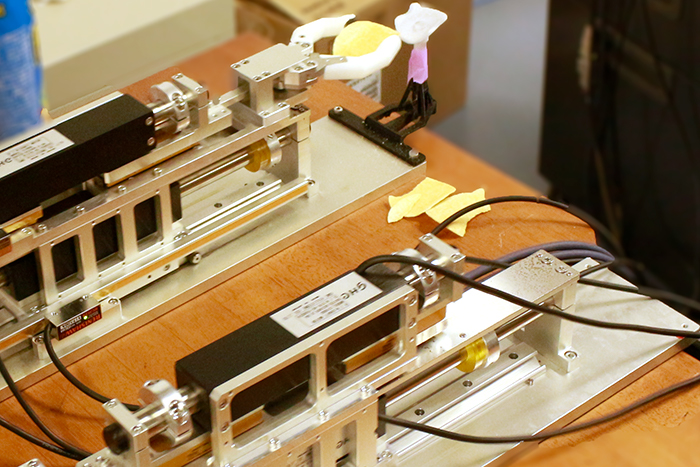

溝口:そうです、いま「力加減してやさしく触る」をお見せしたので次は「触った感触を増幅させる」機能についてご説明します。

この装置の先にふわふわの綿があります。これを「触った感触を10倍」にしたらどうなるか。

おそらく綿ではない別の物質を触っているかのような感覚になると思います。

しかしこのとき指に伝わっていたのは【堅めのゴムボール】に触れた感覚だった。

これを何に応用できるかというと、手術時には毛細血管や薄い膜、胎児など「目に見えないほど小さい・薄いもの」を扱うことがあります。

毛細血管を結ぶ手術用の糸は、目に見えないほど細く「指先の感覚」に頼って力加減はできません。力をかけ過ぎればちぎれてしまい、緩く結んだらほどけてしまう。

結局、熟練した医師の経験と勘が頼りです。

しかしその「勘」を若い医師や手術用ロボットに教えるのはとても大変です。

この装置を使って感覚自体を増幅し、普通の糸を結ぶような感覚で力加減を学ぶことができますし、そこで取得したデータをロボットに搭載させることができます。

―この「感覚を増幅させている」は、データ化した力触覚を加工しているのでしょうか。

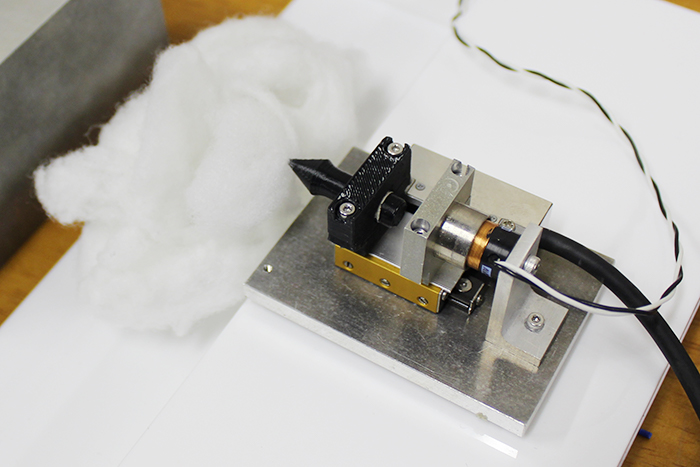

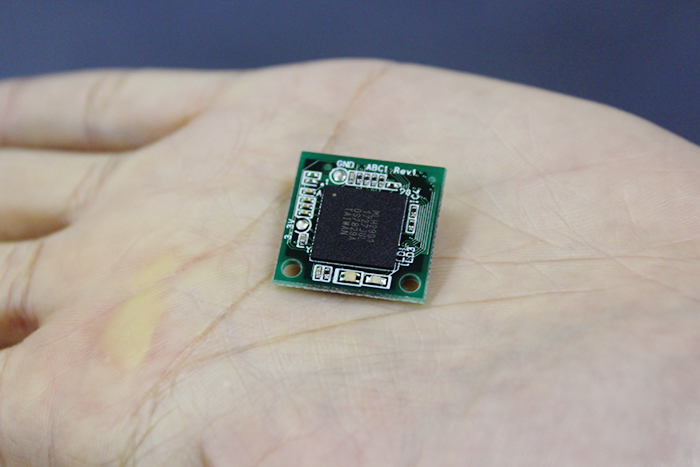

溝口:はい、その処理を行っているのがこのABC-COREというチップです。

力触覚データはかなり複雑な計算を必要としますが、チップを小型化し電源を入れてすぐに動くという特色があるので、あらゆる活用の可能性が出てきました。

この技術で大事なのは「実際の触った感覚」のデータを扱っている点です。

あくまで錯覚ではなく実際の物理現象をデータ化しているので「リアル」ハプティクス技術と呼んでいます。

当初タンスのように大きかったものを小型化したことで様々な機械やロボットに搭載できる可能性が拡がった。

■力触覚をデータとして活用する「ABC-COREチップ」は人を重労働から解放する

―既にリアルハプティクス事業では30社近くの企業と共同研究を進めていますが、具体的にどのような市場・業界での活用が多いですか?

溝口:自社の製造装置に搭載するような「産業機械分野」ですね。

リアルハプティクス技術を使うとちょっと位置がずれたり大きさの異なるものでの「持ち運ぶときの力加減を調整」が可能です。

工場内や製造工程において力加減が大事なケースはとても多く、FA(ファクトリーオートメーション)分野はかなり進んでいますが、それでも作業現場を無人化できない。

その理由は最後のはめ込みや形を合わせるという繊細で力加減が重要な作業に人手がいるというものです。

「ちゃんと“カチッ”とハマったか」の感覚って、人間でしか難しいので、どうやればロボットにその作業を代替できるか?とリアルハプティクス技術に注目が集まっています。

※CEATECに展示されたリアルハプティクス技術のデモ。

見た目と大きさが似ている豆腐・紙粘土・プラスティックを「触った感覚」で力加減して持ち上げる様子

―工場内の無人化以外に、人の近くで作業をするようなケースもありますか?

溝口:はい、農作業に使うというものもあります。

今年10月のCEATEC JAPANでも共同研究している企業と共同で展示した「みかんの収穫ロボット」です。実際に展示したのは、色が全く同じの豆腐・紙粘土・プラスティックを複数置いて、これをリアルハプティクス技術で持った瞬間に判断し、適切な力加減で運ぶというものです。

みかん農家では60歳を超える人たちが夜遅くまで作業しています。

「昼間に収穫」→「翌朝に出荷」のあいだに、収穫が終わったあと翌朝まで腐っているものを取り除いたり大きさ毎に分別する作業を、1つ1つ手でやっています。

この重労働を自動化しようという試みです。

リアルハプティクス技術と画像認識を合わせればみかんを持った瞬間に腐ったものはわかるし、大きさ・重さで分類もできます、みかんを握りつぶしてしまうこともありません。

他にもCEATECではゲーム・アミューズメントの方やタッチセンサーを扱うスマートフォンメーカーなどから反響を頂きました。我々もこのリアルハプティクス技術をなるべく身近に感じてもらうためそういった生活に身近な分野とは何か取り組んでいきたいと考えています。

■いまの社会は「操作方法」に溢れている。もっと感覚的に過ごせる生活があるはず

―いまのは国内企業の話が中心だと思いますが、海外からもリアルハプティクス技術への反響はありますか?

溝口:結構連絡が来ますね。

海外企業の方は「自社でこういう装置を作っていて、ここにABC-COREを搭載したいんだ」非常に具体的なレベルで相談を持ち掛けてきます。

日本だと「この技術は面白いので何に活かせるか包括的に検討しよう」というパターンも多いですが、海外企業の場合CEO自ら僕らの出展ブースに来て具体的な相談をその場でどんどん投げかけてくるのが印象的です。

海外だと特に中国系企業と話すケースが多く、他にもタイやベトナム企業が熱心に僕らの技術を見ているなという印象を持っています。

―もともとモーションリブを法人化したきっかけを教えてください。

大志万COO:このオフィスの横にある「慶応義塾大学ハプティクス研究センター」からスピンアウトしました。ハプティクス研究センターは、触覚を伝える技術を長年研究していた大西研究室が中心となって、かなり産業化が見えてきたという段階で2014年に設立されました。

ハプティクス研究センターは30社以上の企業とハプティクス技術の共同研究を進めているのですが、技術を簡単に実装してもらうためにABC-COREチップを開発し、この産業応用・事業展開を担う役割としてモーションリブが設立されました。

ですから創業時点で、取締役3人中2人はハプティクス研究センターの研究員がそのまま務める形で始まっています。リアルハプティクス技術の学術的な発展・研究は引き続き大学・ハプティクス研究センターが担いつつ、産業界での活用を我々モーションリブが担っています。

しかし就活を通じて「ハプティクス技術を実用化するなら研究室からスタートすべき」と再認識しモーションリブの代表となった。

―会社のメッセージにもある“機械が人を優しく支援”していった先で「世界はこうなっている」と描く未来像のようなものはありますか?

溝口:さっき僕が言った「感触の情報は目や耳よりも原始的」という話に繋がりますが、感触の情報をあらゆる場所で活用したらもっと直感的・感覚的な世界になると思います。

たとえばボタンを押したら開く自動ドア。

ボタンの位置を目で確認して、指でボタンを「前に」押す、すると「横に」ドアが開く。

正しい操作方法ですけど、よく考えると変ですよね。

横に開くドアなら、横に開こうとした瞬間に「すーっ」と開くほうが自然だし、楽なはず。

社会のありとあらゆるものが感触を認識できたら、もっと感覚的に日々を過ごせるのではないかと。

―僕らがボタンの操作方法に慣れただけで、もっと楽に自然に過ごせる世界があるのではと

溝口:はい、オフィスで椅子の高さを調節したい。

操作方法がわからないから調節できない。これおかしいですよね。

ちょっと下げたいなら、「すっ」と下がる方が自然なはずです。

こういうことに興味を持ったり感動できることが大事だと思います。

リアルハプティクス技術に限らず、新しい可能性をもつ技術に触れたとき素直に「凄い!」って思える、このわくわくする気持ちが、新しい何かを作るときの大事な原動力になると思います。

いまモーションリブは手術用ロボットや産業用装置の自動化、という切り口の技術ですが、

「感触」が情報・データとして活用できるようになれば、モーター・動力のあるものにはすべて展開できます。洗濯機、掃除機、家のドア、車・・・日常に自然と溶け込んでどこでも使われていて、人がやろうとしたこを「すっ」と自然にやってくれる、そういう世界にしたいですね。

溝口貴弘 モーションリブ株式会社 代表取締役CEO

昭和62年7月22日生まれ。平成22年3月、慶應義塾大学理工学部卒業。同26年9月、同大学大学院後期博士課程を早期修了。博士(工学)。同27年4月より神奈川科学技術アカデミー(現 神奈川県立産業技術総合研究所)常勤研究員として力触覚技術を利用した医療・福祉介護装置の研究を実施。同28年4月より慶應義塾大学ハプティクス研究センター共同研究員を兼任し力触覚技術の実用化活動を推進。同29年4月に力触覚技術事業化のためモーションリブ株式会社を設立、代表取締役CEOを務める。

インタビュー:波多野智也(アスタミューゼ株式会社)

-

Interview2017.12.12 TUE 3Dプリンターで心臓の治療に貢献する。技術的に難しいからこそ挑戦する! -株式会社JMC…「メイカーズムーヴメント」以降、脚光を浴びた”3Dプリンター”あらゆる業界のものづくりを変革する、と…

Interview2017.12.12 TUE 3Dプリンターで心臓の治療に貢献する。技術的に難しいからこそ挑戦する! -株式会社JMC…「メイカーズムーヴメント」以降、脚光を浴びた”3Dプリンター”あらゆる業界のものづくりを変革する、と… -

Interview2017.08.31 THU 患者を救うため、医療エビデンスに基づいた「治療効果のあるアプリサービス」を確立させる ー …スマホアプリは私たちの生活を劇的に変化させ、世界中に様々な利便性を提供しました。 自らも医師であり、…

Interview2017.08.31 THU 患者を救うため、医療エビデンスに基づいた「治療効果のあるアプリサービス」を確立させる ー …スマホアプリは私たちの生活を劇的に変化させ、世界中に様々な利便性を提供しました。 自らも医師であり、… -

Interview2017.07.20 THU Jiksak bioengineering川田さん「ALS(筋萎縮性側索硬化症)という難病…ALS(筋萎縮性側索硬化症)。近年はソーシャルメディアの「アイスバケツチャレンジ」キャンペーンで話題…

Interview2017.07.20 THU Jiksak bioengineering川田さん「ALS(筋萎縮性側索硬化症)という難病…ALS(筋萎縮性側索硬化症)。近年はソーシャルメディアの「アイスバケツチャレンジ」キャンペーンで話題… -

Interview2018.10.31 WED 医療・介護用ベッドがIoT化? 医療を救う「スマートベッドシステムTM」――パラマウントベ…超高齢化社会を迎え、2060年には高齢化率が約40%に達すると言われる日本。 高齢化社会への対応は急…

Interview2018.10.31 WED 医療・介護用ベッドがIoT化? 医療を救う「スマートベッドシステムTM」――パラマウントベ…超高齢化社会を迎え、2060年には高齢化率が約40%に達すると言われる日本。 高齢化社会への対応は急…