2017.07.18 TUE 音声時代の感情解析AI「Empath」が人に寄り添う未来 ー 株式会社Empath 下地さん・山崎さんインタビュー

| text by : | 編集部 |

|---|---|

| photo : | 編集部,スマートメディカル株式会社 |

Amazon echo、Google Assistant、マイクロソフトのcortana、国内ではLINEの発表したClova(クローバ)、

Appleもsiri搭載のhomepodを発表と、まさに音声アシスタントが本格的な普及期を迎えつつある。

そして音声による感情解析AIのEmpathというサービスが、昨年から注目を集めている。

APIの提供もスタートし、本格的な海外展開も開始されたこのEmpathについて、株式会社Empathの下地さんと山崎さんにお聞きしました。

(※インタビュー時点ではスマートメディカル社の事業、後に分社化し株式会社Empathとなっています。)

■クリニックに来られない人のケアができないか、という問題提起から出発

―Empath誕生の経緯はどういうものですか?

下地(写真左):元々は、会社の事業として医療モールを開発しているのですが、クリニックに訪問してきた方はケアできてもその場に来られない方のケアができない。それを可能にするサービスはどうしたらできるのか、という問題提起が出発点です。

そこで、とりわけメンタルヘルスに着目し、様々な技術調査を行っていく中で音声から感情を解析する技術に行きつきました。ちょうど2011年頃です。そこからEmpathの開発を進めていきました。

―実際にプロダクトをローンチしたのはいつ頃ですか?

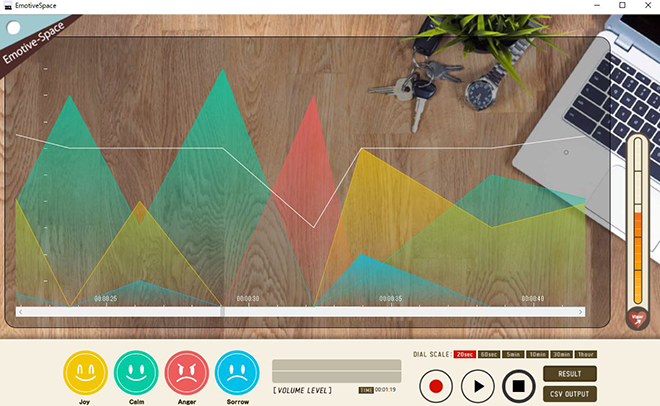

下地: 2013年にNTTドコモさんと共同で仙台市の仮設住宅の支援員さんを対象に、Empathを使った気分チェックによるメンタルケアの取り組みを行いました。これがEmpathをつかった最初の事例です。

支援員の方が毎朝出勤した際に「おはようございます」と音声を入れてもらい、調子が悪い解析結果が出た場合には早めに休みを取ってもらったり、医師との面談を推奨することでサポートを行いました。この経験が後にリリースするストレスチェック義務化対応アプリ「じぶん予報」に繋がっていきます。

―音声による感情解析の仕組みを教えてください。

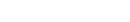

山崎(写真右):ボリューム、ピッチ、スピード、イントネーションなど音声の物理的特徴量を解析することで、感情解析を行っています。

Empathは平常、喜び、怒り、悲しみの4つの感情と元気度を測定することができます。元気度は4つの感情値を構成要素とする指標で、気分状態を測定する質問紙POMS(Profile of Mood States)との相関をもとに作成したものです。

―このインタビュー中も実際にEmpathで計測をしていますが、かなりリアルタイムに近い、早い処理をしていますよね。

下地:データ処理の根底は機械学習モデルで作成しています。

サンプル音声を集めるのが大変なのですが、僕らははじめに約4万の音声データを収集してEmpathを開発しました。現在はAPIのユーザーから音声データを獲得しており、その数は日に日に増大しています。

アルゴリズム自体も修正を繰り返していますし、リアルタイムに感情解析ができるところも競合に対するEmpathの強みです。データ量、アルゴリズムの磨き方、高速処理の実行など、後追いで出てくる企業がいたとしても易々とは追いつけないと思います。

■言語に依存しない感情解析

―2011年頃からスタートして、ここ1年は特にイベント出展や各企業での導入など次のフェーズに移行する雰囲気を感じるのですが。

山崎:そうですね、2016年を「海外進出元年」と捉えて動いた結果、一気に市場が広がったと思います。

とりわけWeb Empath APIをリリースしてから海外でのEmapth利用が増えており、現在では40か国以上のディベロッパーにAPIを使ってもらっています。また、APIの利用者からは音声データを頂いているので、各国の音声データが集まってきています。この音声データを活用することで、Empath自体、日々賢くなっているんです。

また、海外展開の中でも特にプロジェクトが進んでいるのがアラブ首長国連邦でして、連邦内務省にEmpathを採用して頂くなど、政府との連携も深まってきています。

―最近はamazon echoや国内のLINEなど音声インターフェースも盛り上がっています。

下地:そうですね、その中でもとりわけ今年のCESは象徴的でした。展示されていた約700以上のプロダクトの中にAlexaが搭載されており、まさに音声時代の到来を体現していました。

―海外展開するうえで、外国語の解析はどうしているんですか?

山崎:Empathは、何を言っているのかではなく、どう言っているのかを解析しています。ですから、外国語であっても解析可能です。言語ではなく、あくまで音声の物理的特徴量を解析していますから。

下地:現在の音声インターフェースは「テキストの意味・内容」を処理している一方で、その周囲に存在する感情のデータを活用していません。

山崎:API提供により日本語だけでなく外国語の音声を教師データとして活用出来るのは非常に意義があるのですが、一方であらゆる言語の音声コーパスを作成することは不可能です。そこで個人特性にあわせて解析をチューニングしていくキャリブレーションの機能もEmpathに持たせています。

―APIの利用拡大において、どういうジャンルの方に使って欲しい、という希望はありますか?

下地:音声コントロール型のIoTサービスやデバイスを作っている方には是非利用してほしいですね。

音声データが蓄積されることで「この人、いつもと違うな」という気分の変化を計測できることの価値は大きいはずです。

―音声をもとに感情を解析する技術の歴史を知りたいのですが。

山崎:音声感情解析自体の基礎研究は1970年代からすでに存在しています。ただ、感情解析が研究領域として注目をあびはじめるきっかけはMIT Media Lab.のRosalind Picardの1997年の著書Affective Computing(未邦訳)に端を発しているのではないかと思います。実際MITにはPicard教授が率いるAffective Computing(※)という学科が存在しており、ここからは表情解析で有名なAffectivaなど、いくつかの感情解析のスタートアップが誕生しています。

実際、研究領域だけではなくビジネスの領域でもAffective Computingは注目を増しており、2016年に発表されたガードナーのハイプサイクルによると、ブロックチェーンやIoTプラットフォームのちょうど次あたりに盛り上がってくるテクノロジー分野として期待されています。

※Affective Computing(読み:アフェクティブコンピューティング)・・・人間の感情や情緒に関係するコンピューティング分野。

■テレマーケティングにおける購買と感情データの関係

―IoTプラットフォームの次、というともう間近に感じます。

山崎:Affective Computingの市場は2020年までに5兆円を超えるだろうと見込まれています。

表情解析や、IBMのWatsonが行っている言語のセンチメント分析ウェアラブルデバイスによる心拍や皮膚電位ならびに呼吸の測定によるストレスの測定など、Affective Computingの領域では様々な方法で感情解析が行われていますが、僕らの強みは音声に注目している点です。

というのも、amazonやグーグル、LINEなどが次々とスマートスピーカーを発表していくなかで、音声が現在のテクノロジーのキー・ワードであることは間違いないからです。実際、アメリカだけでも、2020年までには2000万世帯にスマートスピーカーが浸透するという予測がなされています。

―実際の製品情報や導入事例を見ると、既にコールセンターや職場・自宅向けなど様々ですね

山崎:音声感情解析の分野で世界で最もユースケースが多いことがEmpathの強みです

データに関しても、ただデータを取得だするだけではなく、例えば職場であれば元気度が一定の数値を下回ると離職率の上昇に繋がるというデータを基にマネージメント層にアラートを送るとか、店舗であれば元気度が一定の数値を上回ると売上が向上するというデータをもとにモチベーションの向上につなげるなど、生産性向上や売り上げへの貢献にも活用しています。

―言える範囲で、音声感情解析で明らかになった事実とかありますか

山崎:コールセンターの事例で興味深い傾向が分かってきました。

オペレーター、お客様両方のデータを計測しているのですが、オペレーター側の「元気度が高い」と成約率も高い。これは直感に一致する結果だと思います。

―ハキハキと話す人のほうが、気分いいですもんね。

山崎:そうです、一方お客様側なのですが。当然最終的に「買う人」と「買わない人」に分かれますけど、両者の感情値には特異的な差異があります。

最終的に買う人は購入の手前で「悲しみ」の感情が強くなります。

―え。欲しいものを買うのに、喜びの感情が強い、ではない?

山崎:購入する人は、悩んで慎重に検討します。

でも興味が無い人は、感情が揺れません。平常でフラットな状態。

だから購入する人は、購入しない人に比べて感情が悲しみに振れやすいんです。

―説明されると、納得感ありますね。

山崎:こうしたデータを蓄積、解析していけばたとえばamazonの音声アシスタントに組み込んだときに、「もう1品購入する確率」を数%でも向上させることに寄与できるはずです。大きな売上効果になりますし、マーケティングにも活用できると思います。

■人に寄り添い、メンタルヘルスの領域に取り組む

―Empathに関わる方々のお話も聞こうと思うのですが、実は山崎さんの名刺に「博士課程」とあるのが気になりまして。元々医療領域でも音声関連の経歴でも無いんですね。

山崎:僕は大学では比較文学科に属していて、文学研究や哲学に興味を持っていました。

近年、人工知能の話題が多い中で「強いAI・弱いAI」が取り上げられることも増えましたが、あれはジョン・サールという哲学者が “Minds, Brains and Programs”という論文のなかで展開した有名な「中国語の部屋」という思考実験において展開した用語です。

※参考リンク:Stanford Encyclopedia of Philosophy

―中国語の部屋、は僕も多少知っていました。

山崎:「AIとはなにか?」という問題にも興味がありましたから、感情解析のプロジェクトに携わることはこうした問いに対して向き合ういいきっかけにもなりました。

こうした問いを考察すると同時に、単に思考するだけではなく現実世界でどのようにこの技術を活用していくのか、どのように人の役に立てていくのかを実践を通して体験できるのもこの事業の面白いところです。とくに、人に寄り添うというコンセプトを掲げてメンタルヘルスの領域に取り組む会社の姿勢には共感しています

―メンタルヘルスケアの問題に繋がっているからこそ、という事ですね。

山崎:そうですね、音声の感情解析はイスラエルなどでは軍事的な背景からも開発されてきたものでもあるので。他社のの感情を「暴く」という方向に向かってしまうこともあります。僕らは「暴く」ことには興味はなくて、あくまで「心に寄り添うツール」としてこの技術を磨いていこうとしています。

弊社の医療モール開発の事業部には、医療に関わってきた経歴の人が多いのですが、

僕らのICT事業には多様なバックグラウンドの人が集まってきています。最近ではフランスでアフェクティブコンピューティングを学んでいたカドリリンガルのデータサイエンティストが入ってくれて、国際色も豊かになっています。

―経歴上はバラバラですが、なにか共通項ってありますか

下地;代表の柴﨑が、元々医療分野のプロフェッショナルなのですが、経歴問わず「俺の下に来なよ」という懐の広さがあって視野も多角的で、それが影響していると思いますね。

山崎: たしかに僕なんか生意気で「こうやりましょうよ」とか勝手な意見を言ってしまうんですけど、ちゃんとお互いに耳を傾けるというか、オープンな関係性が担保されている会社だと思います。

■人間に近づけるのではなく、心に寄り添うコンピューティングを目指す。

―最後に、5年後10年後に向けてのビジョンを教えてください

下地:まず、世の中はこれから急速に音声インターフェースが普及し、人類が音声をどんどん入力する時代になります。僕らのEmpathはそのインターフェースの中に入っていって、音声入力デバイスの所有者1人1人の音声データを蓄積し、それらの音声の感情データを掌握できればと思っています。

そのうえでサードパーティ企業がどんどん乗り入れてくることで、どの音声インターフェイスを使っていてもEmpathが入っていて、使用者の心を察知して動くサービスが作れる。このような、感情を扱う「アフェクティブコンピューティングのプラットフォーム」の実現を目指しています。

―どのデバイスを使っていても、こちらの感情を察してくれる世界

下地:そう、IoTという言葉が流行る前に「ユビキタス」ってあったじゃないですか、それに近い気がします。

今はモノと人が「指令を出して、指示通り動く」関係にあります。数年後には「モノは人に対してどうふるまうべきか」という問いへのの回答が出ている気がします。

その時、心に寄り添うコンピューティングでなければいけない気がします。

人がどうしたいかを判断し、心地よく生きられる世界。

―テクノロジーが人類滅ぼすとかではなくて、真逆の世界。

山崎:そうですね、そのためにも機械側が「世界を認識しやすくする方法」を作る必要があると思います。

例えば音声解析であれば、いわば人間の耳に近い機能と言えますが、人間と同じように情報を認識しているわけではないので、そこを踏まえた上で「機械だからこそできること」をやってもらう。

―いま思ったのですが音声で感情を読み取る時、人間同士だと「受け取り側」に左右されますよね。自分が悲観的な気持ちだと相手の声を悲観的な内容に受け取るとか。

山崎:そうですね。人間の認識は認識する側の状態によって変化します。

例えば恋人を見た時に、いつもとメイクも何も変えてないのに「今日はきれいだな」と感じる。これは対象の問題ではなく認識する側の問題です。

―機械に任せたほうが可能性あると思います。

山崎:テクノロジーで感情を解析することは、モノを人間に近づける事とは全然違うんです。

主観の無い機械だからこそ、人間に不可能な事を委ねられる。

機械のいいところは、環境に依存しないこと。

「何だか気分が悪いから、昨日より恋人が美しく見えない」ということには、機械の場合ならないでしょ(笑)

(※インタビュー時点ではスマートメディカル社の事業のため、当時の肩書で表記しています。)

スマートメディカル株式会社

下地 貴明 取締役 ICT事業本部長

山崎 はずむ ICT事業本部 企画マーケティング部 兼 国際事業部

東京大学大学院 総合文化研究科 博士課程、青山学院大学 社会情報学部 特別研究員

インタビュー:波多野智也(アスタミューゼ株式会社)

この記事に関連するページはこちら

-

News2015.09.15 TUE 「有機EL照明」市場とは?2015年2月14日~4月13日、ハウステンボスで開催された「チューリップ祭」には、約5,000本の…

News2015.09.15 TUE 「有機EL照明」市場とは?2015年2月14日~4月13日、ハウステンボスで開催された「チューリップ祭」には、約5,000本の… -

Interview2019.12.16 MON 宇宙の課題と向き合う民間企業。2020年、前人未到の挑戦へ。(前編) ——株式会社アストロ…2015年9月の国連総会で採択された持続可能な開発のための2030アジェンダ「SDGs(Sustai…

Interview2019.12.16 MON 宇宙の課題と向き合う民間企業。2020年、前人未到の挑戦へ。(前編) ——株式会社アストロ…2015年9月の国連総会で採択された持続可能な開発のための2030アジェンダ「SDGs(Sustai… -

News2015.05.12 TUE ディズニーの「位置に敏感なおもちゃ」あのディズニーが「位置に敏感なおもちゃ」に関する技術を持っていることをご存知だろうか。

News2015.05.12 TUE ディズニーの「位置に敏感なおもちゃ」あのディズニーが「位置に敏感なおもちゃ」に関する技術を持っていることをご存知だろうか。 -

Career2021.06.10 THU 【挑戦する中小企業_福島県双葉郡】震災を乗り越え、ふるさとから世界へ、未来を切り拓く --…忘れもしない東日本大震災。震災と同時に本社を失った福島県双葉郡富岡町。 未曽有の大震災から10年。復…

Career2021.06.10 THU 【挑戦する中小企業_福島県双葉郡】震災を乗り越え、ふるさとから世界へ、未来を切り拓く --…忘れもしない東日本大震災。震災と同時に本社を失った福島県双葉郡富岡町。 未曽有の大震災から10年。復…